Katja Muñoz für bpb.de

10.10.2024

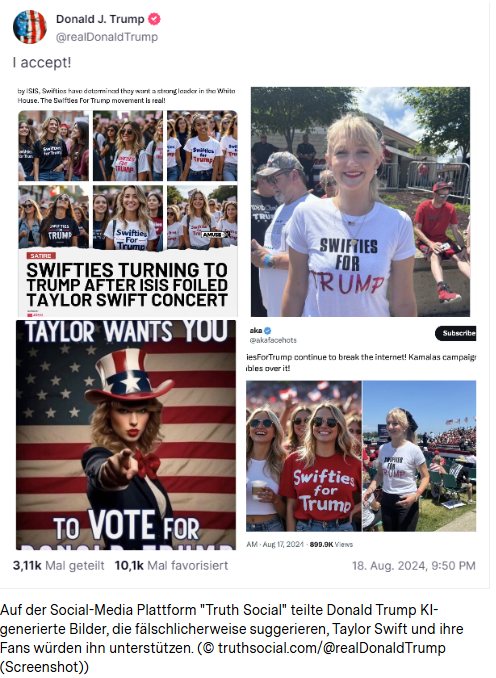

Ende August 2024 postete US-Präsidentschaftskandidat Donald Trump mehrere KI-generierte Bilder, die suggerierten, Popstar Taylor Swift und ihre Fans, die „Swifties“, würden ihn unterstützen. Obwohl sich das schnell als falsch herausstellte (und Swift letztlich ihre Unterstützung der Demokratischen Kandidatin Kamala Harris bekannt gab), zeigt dieser Vorfall, wie Menschen versuchen, die öffentliche Meinung durch KI-generierte Inhalte zu beeinflussen. Mit wenigen Klicks können Falschinformationen erstellt und über soziale Medien verbreitet werden. Vor allem audiovisuelle Inhalte prägen sich schnell ein und können dazu beitragen, Meinungen zu beeinflussen und sogar das Vertrauen von Bürgern in politische Prozesse zu untergraben.

Abhängig von ihrer Nutzung kann KI sowohl einen Beitrag zur Demokratie leisten, als auch ein erhebliches Risiko für diese darstellen, in jedem Fall ist sie im Zusammenhang mit Wahlen nicht mehr wegzudenken. Bisher lässt sich beobachten, dass die Technologie Wahlkampfstrategien revolutioniert, Wahlprozesse automatisiert, und die Erstellung von Inhalten beschleunigt, die dann über soziale Medien verbreitet werden können. KI verändert die Wahlen in den USA grundsätzlich. Der Einsatz dieser neuen Technologie ist vor allem im Wahlkampf sichtbar, verändert den Handlungsspielraum politischer Akteure und wirft wichtige ethische und rechtliche Fragen auf.

Abhängig von ihrer Nutzung kann KI sowohl einen Beitrag zur Demokratie leisten, als auch ein erhebliches Risiko für diese darstellen, in jedem Fall ist sie im Zusammenhang mit Wahlen nicht mehr wegzudenken. Bisher lässt sich beobachten, dass die Technologie Wahlkampfstrategien revolutioniert, Wahlprozesse automatisiert, und die Erstellung von Inhalten beschleunigt, die dann über soziale Medien verbreitet werden können. KI verändert die Wahlen in den USA grundsätzlich. Der Einsatz dieser neuen Technologie ist vor allem im Wahlkampf sichtbar, verändert den Handlungsspielraum politischer Akteure und wirft wichtige ethische und rechtliche Fragen auf.

Deepfakes im US-Wahlkampf

KI ermöglicht die schnelle und einfache Erstellung von Content. Mit nur wenigen Prompts können Texte, Bilder und Videos erstellt werden. Darüber hinaus ist die benötigte Technologie zugänglich – ein Internetzugang und eine kostenlose Registrierung auf einer Tech-Plattform wie OpenAI oder Anthropic reichen aus, um künstliche Inhalte zu erstellen.

Laut einer Verbraucherstudie von 2024 gaben 72 Prozent der befragten US-Amerikaner an, dass sie befürchten, sogenannte Deepfakes – synthetisch generierte Audio-, Bild- und Videoinhalte – könnten zukünftige Wahlen in ihrem Land beeinflussen, und 56 Prozent glauben, die aktuelle Gesetzlage zur Regulierung von KI geht nicht weit genug. [1] Eine noch nicht veröffentlichte Analyse von Nachrichtenportalen durch die Deutsche Gesellschaft für Auswärtige Politik (DGAP) hat ergeben, dass zwischen Januar und Juli 2024 insgesamt 114 KI-generierte Deepfakes im Kontext des US-Wahlkampfs registriert wurden. In dieser Statistik werden keine KI-Posts, die in sozialen Medien geteilt werden, berücksichtigt, sondern nur solche, die von Nachrichtenportalen erwähnt wurden, da die Zahl sonst in die Tausende gehen würde und nicht vollständig erfassbar wäre.

Bereits bei den Vorwahlen der Republikanischen Partei konnte man beobachten, wie KI-generierte Bilder eingesetzt wurden, um bestimmte Botschaften zu unterstreichen oder Bürger davon abzuhalten, zur Wahl zu gehen. Ron DeSantis, Gouverneur von Florida und Republikanischer Präsidentschaftskandidat in den Vorwahlen, teilte ein Deepfake, das eine Nähe von Trump zu Anthony Fauci suggerierte – ein wissenschaftlicher Berater des Weißen Hauses, der unter Donald Trumps Stammwählern sehr negativ gesehen wird –, um Trump bei seinen Stammwählern zu diskreditieren. An dem Beispiel wird offensichtlich, wie einfach es geworden ist, irreführende Behauptungen mit Bildern zu untermauern, zumal dies nicht strafbar ist.

Noch schwerwiegender war die Ankündigung des Generalstaatsanwalts von New Hampshire Anfang des Jahres, dass er einen Fall möglicher Wählerunterdrückung untersuche. Zuvor seien Beschwerden eingegangen, wonach eine „künstlich erzeugte“ Stimme im Tonfall von US-Präsident Joe Biden Wähler angerufen und sie aufgefordert habe, nicht an den Vorwahlen des Bundesstaates teilzunehmen. Dieser so genannte Robocall sollte die Bürger vor Ort von der Stimmabgabe abhalten. Die Auswirkung dieses Versuchs ist bis heute schwer abzuschätzen, da man sich hier auf Einzelberichte verlassen muss. Als Reaktion darauf hat die Federal Communications Commission (FCC) – jene Behörde, die Kommunikation über Rundfunk, Satellit und Kabel in den USA reguliert – den Einsatz von KI-generierten Audio- oder Text nachrichten am Telefon unter Strafe gestellt. [2]

Für und Wider von KI-gestütztem Wahlkampf

KI-generierte Inhalte sind aus den sozialen Medien nicht mehr wegzudenken. Die Befürchtung, dass manipulative synthetische Inhalte im Wahlkampf um die US-Präsidentschaft eine große Anzahl an Menschen beeinflussen könnten, hat sich bisher jedoch nicht bewahrheitet. Obwohl KI die verschiedensten Plattformen überschwemmt, scheint es, als würde in diesem Wahlzyklus diese Quelle von Desinformation nicht verfangen. Das liegt vielleicht auch daran, dass bisher keine einzelne KI-generierte Desinformation auf einer Größenordnung Aufmerksamkeit erhalten hat, dass sie den Ausgang der Wahlen beeinflussen könnte. Und das obwohl KI laut Sicherheitsexperten sowohl die Reichweite als auch die Effektivität böswilliger Informationskampagnen generell erhöht.

Auf lokaler Ebene hingegen wird KI im Zusammenhang mit Wahlen bereits auf vielfältige Weise eingesetzt. Kostengünstige und benutzerfreundliche KI-Modelle können Kandidaten, insbesondere in kleinen Gemeinden oder von Parteien mit begrenzten Ressourcen, helfen, Geld und Zeit bei einigen ihrer Aufgaben zu sparen, zum Beispiel bei der Generierung von Plakaten, der Erstellung von Texten, der Analyse von Daten usw. Allerdings verfügen gerade diese Kandidaten oft nicht über das Personal oder die Expertise, um KI-generierte Desinformation zu bekämpfen, weshalb denkbar wäre, dass ein Deepfake kurzfristig genügend Wähler täuschen könnte, um eine knappe Wahl entscheidend zu beeinflussen. Hyperlokale Desinformationskampagnen stellen demnach eine Gefahr dar. Diese Form der strategischen Wählermanipulation auf kommunaler Ebene ist auch deshalb ein großes Risiko, weil Lokaljournalismus in den USA seit einigen Jahren rückläufig ist und über immer weniger Ressourcen verfügt. Der Versuch eines Faktenchecks bleibt oft den betroffenen Kandidaten selbst überlassen und hängt vor allem von deren Ressourcen ab.

Generell lässt sich feststellen, dass KI-generierte Inhalte, insbesondere Bilder und Videos, oft eine bestimmte Ästhetik aufweisen – einen leicht erkennbaren „KI-Look“. Dabei handelt es sich entweder um sogenannte „Cheapfakes“, also synthetische Posts von schlechter Qualität, die leicht zu erkennen sind, beispielsweise wenn Gesichter auf bestehende Videos montiert oder Stimmen verfremdet werden, oder um künstlich erzeugte Bilder und Videos, deren Stil an Animationsfilme erinnert und der mit etwas Erfahrung ebenfalls schnell wiedererkennbar wird. Trotz ihrer oft hohen Qualität sind solche Inhalte leicht identifizierbar und werden häufig als Memes verwendet. Als Sprache der Internetkultur sind Memes leicht verständlich und nehmen bereits viel Raum in den sozialen Medien ein, sind leicht zu teilen und erreichen Millionen von Menschen. Ein Beispiel hierfür ist das von Trump geteilte KI-generierte Bild von Kamala Harris, die vor einer kommunistischen Versammlung spricht, während über der Arena ein riesiges rotes Hammer-und-Sichel-Banner prangt. Das Ziel hier ist klar: Es geht darum, Ihre Politik mit bekannten Symbolen in ein Licht zu rücken, das Angst auslöst.

Generell lässt sich feststellen, dass KI-generierte Inhalte, insbesondere Bilder und Videos, oft eine bestimmte Ästhetik aufweisen – einen leicht erkennbaren „KI-Look“. Dabei handelt es sich entweder um sogenannte „Cheapfakes“, also synthetische Posts von schlechter Qualität, die leicht zu erkennen sind, beispielsweise wenn Gesichter auf bestehende Videos montiert oder Stimmen verfremdet werden, oder um künstlich erzeugte Bilder und Videos, deren Stil an Animationsfilme erinnert und der mit etwas Erfahrung ebenfalls schnell wiedererkennbar wird. Trotz ihrer oft hohen Qualität sind solche Inhalte leicht identifizierbar und werden häufig als Memes verwendet. Als Sprache der Internetkultur sind Memes leicht verständlich und nehmen bereits viel Raum in den sozialen Medien ein, sind leicht zu teilen und erreichen Millionen von Menschen. Ein Beispiel hierfür ist das von Trump geteilte KI-generierte Bild von Kamala Harris, die vor einer kommunistischen Versammlung spricht, während über der Arena ein riesiges rotes Hammer-und-Sichel-Banner prangt. Das Ziel hier ist klar: Es geht darum, Ihre Politik mit bekannten Symbolen in ein Licht zu rücken, das Angst auslöst.

In der Forschung lässt sich derzeit beobachten, dass KI-generierte Inhalte in einem noch nie dagewesenen Ausmaß in Wahlkämpfe Eingang finden, zum Beispiel um Wähler zu mobilisieren, eigene Positionen zu unterstreichen und zu fördern. Eine weitere Auswirkung der Flut an KI-generierten Inhalten scheint zu sein, dass auch authentische Bilder von der Öffentlichkeit immer mehr angezweifelt werden. Dieses als „Liar‘s Dividend“ bezeichnete Phänomen kann ausgenutzt werden und dazu führen, dass zum Beispiel echte Fotos als KI-Bilder diskreditiert werden.

Verschiedene Formen von Vulnerabilitäten

Wie bereits angedeutet, birgt der Einsatz von KI erhebliche Risiken für die Integrität der Wahlen in den USA. Die oben angeführten Beispiele zeigen, dass synthetische Inhalte gezielt eingesetzt werden, nicht zuletzt um lokal begrenzte Wählerunterdrückung zu fördern. Es gibt jedoch auch andere Vulnerabilitäten, zum Beispiel in der Form gezielt sprachbasierter Desinformationskampagnen, die auf bestimmte Bevölkerungsgruppen abzielen in den USA. Vor allem die spanischsprechende Minderheit wird hier oft gezielt angesprochen. Besonders auffällig sind auch Deepfakes, die Politiker persönlich angreifen und das Potential haben, das Vertrauen der Wähler in die politische Führung zu untergraben. Besonders deutlich wird dies am Beispiel der Deepfakes von Präsident Biden: Politische Gegner teilten Audio- und Video-Deepfakes, die bestehende Sorgen um die physische und psychische Gesundheit des Präsidenten verstärkten, und dazu beitrugen, das Vertrauen in seine Person und seine geistige Verfassung zu untergraben.

Neben Deepfakes ist ein weiteres Problem die hyperpersonalisierte Wahlwerbung, die an die Methoden von Cambridge Analytica erinnert. Durch den Einsatz von KI könnten Kampagnen auf einzelne Wähler zugeschnittene Botschaften verbreiten, die deren Meinungen und Überzeugungen verstärken und so zur Fragmentierung der öffentlichen Meinung beitragen. Denn persönliche Daten sowie Nutzerdaten können sehr leicht von Datenhändlern in den USA gekauft und dank KI auch leichter ausgewertet werden. Über diesen Weg wird politische Kommunikation fragmentierter und trägt zur Verschärfung der Polarisierung bei.

Fragmentierte KI-Regulierung

Trotz des Risikos der Irreführung potenzieller Wähler gerade auf lokaler Ebene, gibt es mit Ausnahme des Robocall-Verbots der FCC bisher nur vereinzelte Bemühungen auf nationaler Ebene, diesen Risiken entgegenzuwirken. Auf Bundesstaaten-Ebene sieht es anders aus: Laut der National Conference of State Legislatures arbeiten mindestens 40 Bundesstaaten an entsprechenden Gesetzen für die Legislaturperiode 2024. Viele der Gesetze zielen nicht ausschließlich auf KI-generierte Inhalte ab, sondern allgemein auf sexuell explizite Inhalte und auf solche, die Wähler in die Irre führen sollen. In Bezug auf politische Kampagnen haben mehr als ein Dutzend US-Staaten Gesetze erlassen, die die Verwendung von Deepfakes regeln. Je nach Staat können Verstöße mit Gefängnisstrafen und hohen Geldstrafen geahndet werden; Kandidaten können gar ihr Amt oder ihre Nominierung verlieren.

Das Fehlen einer umfassenden Gesetzgebung und anhaltende Kompetenzkonflikte zwischen den Regulierungsbehörden zeigen, dass sich die USA bei der Entwicklung eines soliden Rahmens für den Einsatz von KI im Wahlprozess noch in der Anfangsphase befinden. Auf Bundesebene muss der Kongress noch einen nationalen Rahmen für die Regulierung von KI, einschließlich KI-generierter Nachbildungen, verabschieden. Es gibt jedoch auch einige parteiübergreifende Gesetzesentwürfe die bereits 2023 im Kongress eingebracht wurden, unter anderem der Protect Elections from Deceptive AI Act, der KI-generierte Deepfakes im Wahlkampf verbieten soll. [3] Der Protecting Americans from Foreign Adversary Controlled Applications Act, auch bekannt als TikTok-Divest-or-Ban-Act, wurde im April 2024 verabschiedet und soll Byte Dance (die chinesische Muttergesellschaft von TikTok) zwingen, ihre Anteile an der App innerhalb eines Jahres zu verkaufen oder andernfalls mit einem Verbot der Plattform in den USA konfrontiert zu werden. [4] Grund dafür sind vor allem Sicherheitsbedenken, wonach die chinesische Regierung über TikTok auf sensible Nutzerdaten zugreifen und die App als Propaganda- und Desinformationsinstrument missbrauchen könnte.

KI-Richtlinien von Big Tech

Soziale Medien und Big-Tech-Unternehmen spielen eine besonders wichtige Rolle bei der Erstellung und Verbreitung synthetischer Inhalte. Es wurden auch im Vorfeld der vielen Wahlen im globalen Superwahljahr 2024 freiwillig einige neue Regelungen von Tech-Unternehmen und sozialen Medien-Plattformen eingeführt, um zu verhindern, dass ihre KI-Tools zur Erstellung politischer Desinformationen verwendet werden, zum Beispiel das Kennzeichnen von synthetisch generierten Inhalten. Trotzdem lässt sich immer wieder beobachten, dass durch cleveres Prompting die entsprechenden Maßnahmen umgangen werden.

Konkurrierende Plattformen wie X, YouTube, TikTok, Instagram und Facebook haben ebenfalls Schritte unternommen, um KI-generierte Inhalte in den Feeds ihrer Nutzer zu kennzeichnen. Wie wenig effektiv diese Richtlinien sind beziehungsweise durchgesetzt werden, zeigt sich am Beispiel von X: Laut der Plattform ist das Teilen von „synthetischen, manipulierten oder aus dem Zusammenhang gerissenen Medien, die Menschen täuschen oder verwirren und Schaden anrichten können“ nicht erlaubt. Elon Musk, der Besitzer der Plattform, teilte im Kontext des Präsidentschaftswahlkampfes jedoch ein Deepfake, das Falschaussagen von Kamala Harris beinhaltet – ein klarer Verstoß gegen die geltende Richtlinie seiner Plattform. [5] In diesem wie in vielen anderen Fällen gab es keine Konsequenzen. Effektive Maßnahmen zur Bekämpfung von KI-generierter Desinformation und ihrer Verbreitung auf Social-Media bleiben bisher aus.

Fußnoten

[1] „2024 Online Identity Consumer Study“, jumio, 2024. Online verfügbar: https://www.jumio.com/2024-identity-study/

[2] „Stop Unwanted Robocalls and Texts“, Federal Communications Commission (FCC), 18.07.2024. Online verfügbar: https:// www.fcc.gov/consumers/guides/stop-unwanted-robocalls-and-texts

[3] „S.2770 – Protect Elections from Deceptive AI Act“, congress.gov, 12.09.2023. Online verfügbar: https://www.congress.gov/bill/118th-congress/senate-bill/2770

[4] „H.R.7521 – Protecting Americans from Foreign Adversary Controlled Applications Act“, congress.gov, 13.03.2024. Online verfügbar: https://www.congress.gov/bill/118th-congress/house-bill/7521

[5] „Ohne Kennzeichnung der Manipulation: Elon Musk teilt Deepfake-Video zu Kamala Harris“, tagesspiegel.de, 29.07.2024. Online verfügbar: https://www.tagesspiegel.de/internationales/ohne-kennzeichnung-der-manipulation-elon-musk-teilt-deepfake-video-zu-kamala-harris-12109496.html

KI und Wahlen: Brennpunkt USA von Katja Muñoz für bpb.de, CC-BY-NC-SA 4.0

KI und Wahlen: Brennpunkt USA von Katja Muñoz für bpb.de, CC-BY-NC-SA 4.0